03 mar. 2023Intelligence artificielle et arts : une mise à jour 1/2

L’homme et les machines

Depuis la sortie coup sur coup de plusieurs applications qui donnent accès via Internet à des logiciels d’intelligence artificielle permettant de générer des images, des sons ou des textes à partir de requêtes formulées en langage naturel, il est devenu impossible d’échapper au déferlement d’analyses et d’interrogations angoissées ou enthousiastes à propos de la signification anthropologique de cette (supposée) brusque montée en puissance de l’IA. Ne venons-nous pas d’entrer dans l’ère posthumaniste, voire posthumaine ? Les arts en particulier, jusqu’ici considérés comme étant par excellence la chasse gardée des humains, ne sont-ils pas en train d’être pris en charge par les algorithmes de l’intelligence artificielle ?

Dans une contribution antérieure consacrée aux relations entre arts et IA, j’avais suggéré que la crainte apocalyptique d’un « grand remplacement » des artistes par les dispositifs d’IA n’était pas justifiée. Cela reste ma conviction mais comme le débat concernant les relations entre machines intelligentes et esprit humain a été relancé sur un terrain plus général par les chatbots (Chat-GTP3 et surtout Bing et ses supposées menaces et déclarations d’amour à l’adresse de ses interlocuteurs humains), il peut être utile de traiter de front la question de base qui nourrit l’inquiétude des uns et l’enthousiasme des autres : est-il possible pour les dispositifs d’I.A. d’atteindre un stade de développement qui leur permette de se muer en êtres doués de conscience, d’intentionnalité, d’empathie etc., et de risquer de « remplacer » les humains ?

Si on pouvait montrer qu’il était sinon impossible du moins très douteux qu’ils puissent accéder à un tel statut, cela rendrait du même coup très douteux qu’ils puissent remplacer les artistes.

Dans la première partie de la présente contribution je tenterai de donner des éléments de réponse concernant cette question générale. Dans la deuxième partie je reviendrai plus spécifiquement à la question des arts en me proposant d’expliciter davantage ce à quoi j’avais fait allusion dans le texte « Intelligence artificielle et art », à savoir que si les produits créés par les générateurs IA ne peuvent pas remplacer les pratiques artistiques existantes, l’IA constitue néanmoins une opportunité indéniable – à l’instar de toutes les innovations ou inventions techniques, par exemple la photo et le cinématographe - pour développer de nouvelles pratiques artistiques fondés sur son utilisation.

La question du statut de l’IA est aussi ancienne que la recherche dans ce domaine, puisqu’elle est au cœur du célèbre « test de Turing », formulé en 1950 par un des pionniers de l’informatique, à savoir le mathématicien Alan Turing. Je rappelle brièvement le principe du test. On fait interagir verbalement et en aveugle une personne avec une autre personne humaine et avec un ordinateur. La première personne pose des questions auxquelles l’autre personne et l’ordinateur donnent des réponses. La première personne a pour tâche d’inférer, à partir des réponses fournies, qui des deux interlocuteurs est une personne humaine et qui est un ordinateur. A partir du moment où l’interrogateur n’est plus capable de faire la différence entre les deux en se servant de leurs réponses, l’ordinateur a réussi le test et donc doit être considéré comme étant capable de penser comme un être humain. Le test a donné lieu une littérature secondaire énorme qui ne me reteindra pas ici. Ce qui importe c’est qu’il a été interprété en général comme démontrant que dès lors un humain est incapable de distinguer entre les réponses que donne un autre humain et celles que donne un ordinateur alors il n’existe plus de différence entre ces deux derniers.

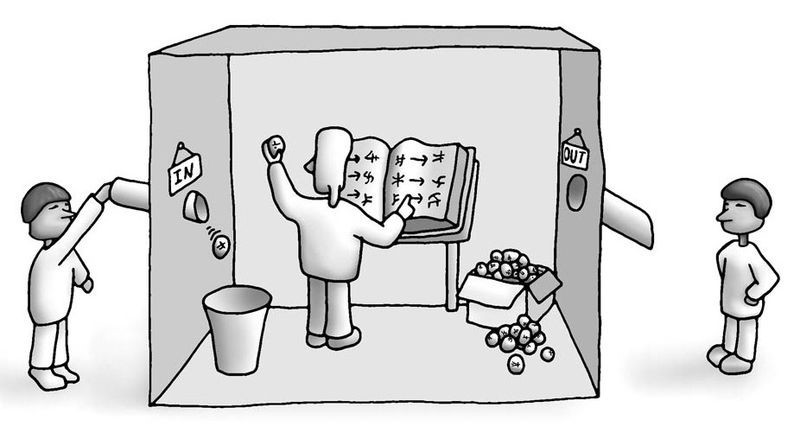

C’est cette interprétation qui a été critiquée par le philosophe John Searle en 1985 dans une expérience de pensée intitulée « La chambre chinoise », qui est devenue aussi célèbre que le test de Turing et a donné lieu à une littérature secondaire tout aussi abondante. Voici l’expérience en question. Dans une chambre on enferme une personne qui ignore tout de la langue chinoise mais qui doit donner des réponses à un interlocuteur chinois qui est à l’extérieur de la chambre et qui lui passe des questions écrites en chinois. Pour donner la bonne réponse, la personne dans la chambre dispose comme seul outil d’un catalogue qui lui a été fourni et qui est constitué de règles de correspondance associant chacune une phrase écrite en caractères chinois avec une autre phrase elle aussi écrite en chinois. Donc, lorsque le locuteur chinois passe une phrase x à la personne dans la chambre, celle-ci cherche cette phrase dans son catalogue puis celle qui lui est associée et passe une feuille sur laquelle cette dernière phrase est inscrite au locuteur chinois. Ainsi celui qui est enfermé reçoit des phrases en chinois et fait passer des phrases en chinois au locuteur chinois. Pour ce dernier, la personne enfermée se comporte donc comme un locuteur qui maîtrise le chinois et qui communique avec lui grâce à cette langue. Et pourtant la personne qui reçoit les questions et donne les réponses ne comprend ni les unes ni les autres et ne communique nullement avec le locuteur chinois : elle se borne à appliquer une règle formelle.

Selon Searle, l’intelligence artificielle se trouve dans la même situation que la personne qui ne comprend pas le chinois mais suit des règles d’ordre syntaxique (donc purement formelles). Le fait qu’une machine réponde aussi bien qu’une personne humaine, au point que le celui qui doit décider qui est qui n’arrive plus à distinguer entre les deux, n’implique donc pas que le logiciel soit doué de conscience et donc communique effectivement. Selon Searle, pour qu’un comportement (linguistique ou autre) puisse être qualifié d’humain, il faut qu’il soit fondé dans et sur un vouloir dire qu’il exprime, ce qui implique qu’il doit disposer d’une agentivité consciente - capable d’entretenir des croyances, des préférences, des valeurs (notamment épistémiques) etc. Or, selon Searle, ce sont là des compétences qui se sont peu à peu développées dans les cerveaux animaux durant l’évolution et qui pour cette raison dépendent radicalement de leur incarnation dans des cerveaux biologiques, ce qui n’exclut pas la possibilité que dans certaines tâches les programmes informatiques puissent dépasser les compétences des cerveaux humains. Pour Searle, la différence n’est donc pas une question d’infériorité et de supériorité mais de « mode d’être » (biologique vs électronique).

La plupart des chercheurs en intelligence actuelle diraient que la concession finale de Searle est la seule chose qui importe pour eux. Selon eux comparaître le statut de l’intelligence artificielle à celui de l’intelligence humaine n’est pas un problème pertinent du point de vue de leurs recherches (d’où le peu d’intérêt qu’ils accordent au test de Turing). Leur but n’est pas de créer des programmes qui soient capables de simuler le plus fidèlement possible l’intelligence humaine, mais qui sont capables de résoudre de la manière la plus efficace possible les problèmes pour lesquels ils ont été créés (par exemple la reconnaissance de visages, la génération ou le morphing d’images, la création d’interfaces machine homme les plus complexes et fines possibles, etc.). Deux spécialistes réputés du domaine, Stuart Russell et Peter Norvig, ont défendu dès 2003 cette manière de voir en l’illustrant par une image parlante : demander à l’intelligence artificielle de simuler le plus parfaitement possible l’esprit humain est aussi absurde que si lors de l’invention de l’avion on avait demandé aux inventeurs et aux ingénieurs de simuler le plus fidèlement possible la forme et la technique de vol d’un pigeon ou d’un autre volatile (Stuart Russell et Peter Norvig, Artificial Intelligence : A Modern Approach, Prentice Hall, 2003, p. 3).

Les plus populaires

- 26 juin. 2024

- 28 juin. 2024

- 05 juil. 2024

- 04 juil. 2024

ARTICLES

Videos

26 juil. 2024TAPAGE avec Ruth Lorang

Articles

22 juil. 2024Le fabuleux destin de Raphael Tanios

Videos

19 juil. 2024